OpenAI si impegna a rendere l’intelligenza artificiale accessibile a un vasto pubblico. E’ stata annunciata ieri GPT-4o mini, il modello di OpenAI più efficiente in termini di costi. Ci si aspetta che GPT-4o mini espanda significativamente la gamma di applicazioni costruite con l’IA, rendendo l’intelligenza molto più accessibile economicamente.

GPT-4o mini ottiene un punteggio dell’82% su MMLU e supera attualmente GPT-41 nelle preferenze di chat nella classifica LMSYS. Il costo è di 15 centesimi per milione di token in ingresso e 60 centesimi per milione di token in uscita, un ordine di grandezza più economico rispetto ai modelli precedenti e oltre il 60% più conveniente rispetto a GPT-3.5 Turbo.

Grazie ai suoi costi e latenza ridotti, consente un’ampia gamma di attività, come applicazioni che concatenano o parallelizzano più chiamate a modelli (ad esempio, chiamando più API), passano un grande volume di contesto al modello (ad esempio, intere basi di codice o storie di conversazione) o interagiscono con i clienti tramite risposte testuali rapide in tempo reale (ad esempio, chatbot per il supporto clienti).

Attualmente, la versione mini supporta testo e visione nell’API, con il supporto per testo, immagini, video e audio in input e output in arrivo nel futuro. Il modello ha una finestra di contesto di 128K token, supporta fino a 16K token in uscita per richiesta e ha conoscenze aggiornate fino a ottobre 2023. Grazie al tokenizer migliorato condiviso con GPT-4o, gestire testi non in inglese è ora ancora più conveniente.

Un modello piccolo con intelligenza testuale e ragionamento multimodale superiore

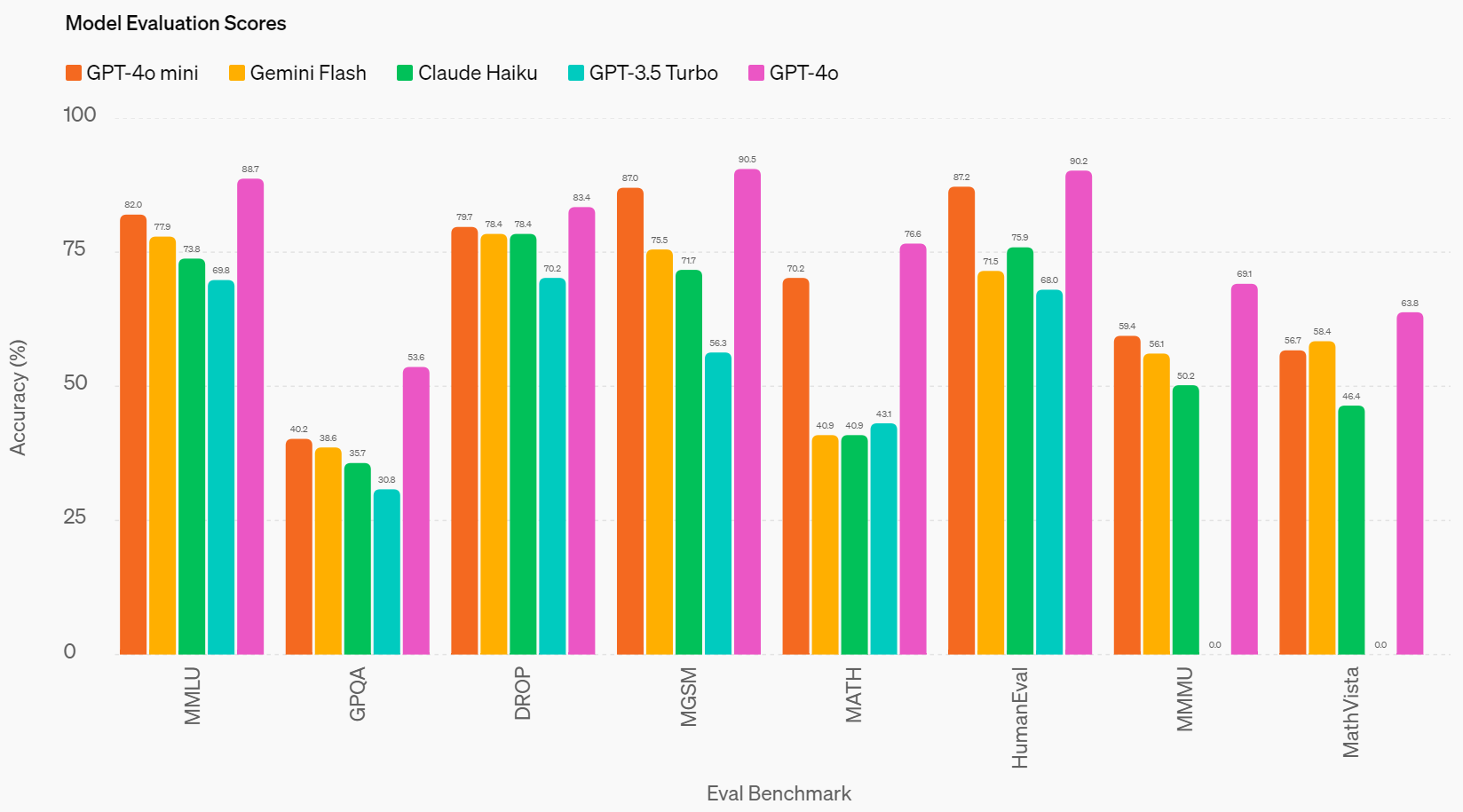

GPT-4o mini supera GPT-3.5 Turbo e altri piccoli modelli nei benchmark accademici sia per l’intelligenza testuale che per il ragionamento multimodale e supporta la stessa gamma di lingue di GPT-4o. Dimostra anche prestazioni elevate nelle chiamate a funzioni, permettendo agli sviluppatori di creare applicazioni che recuperano dati o eseguono azioni con sistemi esterni, e una performance migliorata su contesti lunghi rispetto a GPT-3.5 Turbo. GPT-4o mini è stato valutato su diversi benchmark.

Compiti di ragionamento

ChatGPT-4o mini supera altri piccoli modelli in compiti di ragionamento che coinvolgono sia testo che visione, ottenendo l’82.0% su MMLU, un benchmark di intelligenza testuale e ragionamento, rispetto al 77.9% di Gemini Flash e al 73.8% di Claude Haiku.

Competenza matematica e di codifica

La mini eccelle nel ragionamento matematico e nei compiti di codifica, superando i precedenti piccoli modelli sul mercato. Su MGSM, che misura il ragionamento matematico, GPT-4o mini ha ottenuto l’87.0%, rispetto al 75.5% di Gemini Flash e al 71.7% di Claude Haiku. GPT-4o mini ha ottenuto l’87.2% su HumanEval, che misura le prestazioni di codifica, rispetto al 71.5% di Gemini Flash e al 75.9% di Claude Haiku.

Ragionamento multimodale

GPT-4o mini mostra anche prestazioni elevate su MMMU, una valutazione di ragionamento multimodale, ottenendo il 59.4% rispetto al 56.1% di Gemini Flash e al 50.2% di Claude Haiku.